Intelligente Brillen werden die Sicht auf unser tägliches Leben revolutionieren. Doch wie lassen sich virtuelle Informationen direkt vor das Auge projizieren, oder gar die Netzhaut selbst als Leinwand nutzen?

Die reale Welt durch Zusatzinformationen virtuell anreichern: Was mit Gaming-Anwendungen begann und in Fertigungshallen bereits Einzug gehalten hat, ist auf dem Weg, Teil des täglichen Lebens zu werden. Schon heute haben beispielsweise Monteure dank erweiterter Realität (Augmented Reality, AR) während des Fertigungsprozesses eine Schritt-für Schritt-Anleitung direkt vor Augen. Und damit die Hände frei für die Montage.

Das Prinzip von AR könnte auch im Alltagsleben vieles vereinfachen: auf Reisen die Übersetzung von Schildern oder Speisekarten in Echtzeit vor das Auge projizieren oder die Routenführung beim Fahrradfahren anzeigen. „Doch die aktuell verfügbaren Headsets sind nicht als täglicher, selbstverständlicher Begleiter geeignet. Was wir dafür brauchen, ist eine smarte Brille, die klein, stylish und erschwinglich ist“, erklärt Stefan Morgott, Applikationsingenieur bei OSRAM Opto Semiconductors. Und geht auch gleich darauf ein, warum es so eine Brille noch nicht gibt: „Dafür muss die Technik, die drinsteckt, noch deutlich kleiner werden. Und die Effizienz deutlich größer“. Keine leichte Aufgabe, denn die virtuelle Einblendung von Informationen basiert auf einem hochkomplexen System aus Sensorik, Optik und Projektion.

Die Informationen müssen perspektivisch an die Bewegungen des Brillenträgers angepasst und in das reale Betrachterbild eingeblendet werden. Ein Rechner erkennt die Umgebung mittels Kamera, GPS oder Sensordaten und selektiert die Informationen, die dazu angezeigt werden sollen.

Doppelt virtuell

Zur Erzeugung virtueller Bilder vor dem Auge des Betrachters gibt es verschiedene Ansätze. Stefan Morgott und sein Team arbeiten daran, dafür eine möglichst kleine und effiziente Lösung zu finden. „Es ist weder ein Monitor noch eine Projektion, wie man sie kennt. Es ist doppelt virtuell – ein virtuelles Bild, das im Raum steht“, erläutert Morgott. Denn das menschliche Auge kann je nach Alter nur das scharf stellen, was mindestens zehn Zentimeter entfernt ist. Projektion ist auch nötig, um das virtuelle Bild in der richtigen Größe und auf der richtigen Fokusebene innerhalb der realen Welt anzuzeigen.

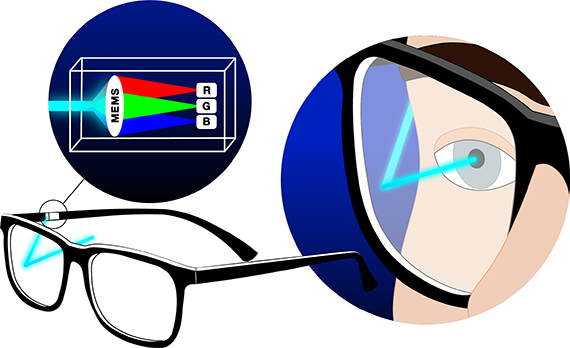

„Es gibt ganz unterschiedliche Konzepte, dies umzusetzen, über passive oder aktiv leuchtende Mikrodisplays oder über einen sogenannten Scanning Mirror. Die derzeit verfügbaren Lösungen sind entweder zu groß, haben eine zu geringe Auflösung, eine zu geringe Leuchtkraft, sind nicht effizient genug oder einfach noch nicht marktreif. Deshalb setzen wir aktuell auf „Laserbeamscanning“, begründet Morgott die Wahl der Visualisierungstechnologie. Mit Lasern kann der Projektor, der am Brillenbügel angebracht ist, super klein, gleichzeitig leicht, hell und energieeffizient gebaut werden. Das macht ihn sehr attraktiv für den Verbrauchermarkt.

Die Netzhaut als Leinwand

Doch besondere Lösungen benötigen besondere Lichtquellen. Die Idee war, die drei Farben Rot, Grün und Blau in einem Laserpackage zu vereinen, um das Displaysystem möglichst klein bauen zu können. Dieser entscheidende Schritt, die Zusammenfassung von drei diskreten R/G/B-Lasern in einem RGB-Laserpackage, ist Morgott und seinem Team jetzt gelungen.

Durch den ebenfalls am Brillenbügel angebrachten Mikroscanner MEMS gelenkt, trifft der Laserstrahl dann in unterschiedlichen Winkeln durch die Pupille auf die Linse. Diese leitet den Strahl fokussiert auf die Netzhaut. Dort baut der Laser durch einzelne Bildpunkte das virtuelle Bild in der Retina auf. Da immer nur mit einem Laserstrahl gearbeitet wird, ist das Displaysystem sehr klein. Gleichzeitig ist die Leistung des Lasers so gering, dass kein Risiko für das Auge besteht.

Direkt auf die Retina zu „malen“, funktioniert nur mit einem Laser. Da der Strahl dafür gezielt ins Auge gelenkt wird, ist nur sehr wenig Licht nötig. Bei allen anderen Displaysystemen strahlt das Licht in alle Richtungen ab – ein Teil davon ungenutzt.

Vom Betrachter werden die Bildinhalte wie Pfeile, Symbole oder Textnachrichten, wahrgenommen, als ob sie vor ihm stehen würden. Große Bereiche innerhalb des Sichtfeldes müssen durchsichtig bleiben. Ein Vorteil der Lasertechnologie: Der Strahl lässt genügend Durchblick auf die reale Welt.

Eine vielversprechende Verbindung

OSRAM hat fast zehn Jahre Erfahrung mit unterschiedlichsten optischen Halbleiter-Technologien für Augmented Reality. Die Zusammenarbeit von Lichtexperten und Sensorspezialisten ermöglicht es, jetzt noch mehr Bausteine von AR-Systemen abzudecken. „Die AR-Brille wird die nächste Generation Hardware in der Verbraucherelektronik“, ist Morgott überzeugt und meint: „Mit unserer neuen Sensor-Mutter ams können wir über die Licht- und Displaytechnologien hinaus auch Sensorik, zum Beispiel 3-D-Sensing für Smart Glasses anbieten“.

Eine mit einem speziellen 3-D-Sensor ausgestattete Brille kann die reale Welt als dreidimensionales Modell darstellen und darin virtuelle Informationen platzieren – ein völlig neues Darstellungserlebnis.

Auch für Eyetracking, die Anpassung der Laserstrahlführung an die Augenbewegung, kommt schon heute die benötigte Lichtquelle von Osram, die Sensorik von ams. Die Technologie kann auch zur Kommandosteuerung genutzt werden: per Blinzeln ein Klick, die Cursorsteuerung über die Augenbewegung. „Die Zukunft im Auge“ gilt für das neue gemeinsame Unternehmen in doppeltem Sinn.